Embodiment, con i robot l’AI avrà un corpo, e sarà a livelli impensabili

C’è un antico dibattito filosofico sulla relazione tra mente e corpo.

Può esistere un’intelligenza pura, slegata da qualsiasi substrato materiale?

O la cognizione è indissolubilmente legata all’esperienza fisica, all’interazione con l’ambiente circostante?

Sono domande che oggi, nell’era dell’intelligenza artificiale, assumono una nuova urgenza.

Perché se è vero che le AI stanno diventando sempre più sofisticate nel processare informazioni astratte, molti ricercatori ritengono che per eguagliare e superare l’intelletto umano dovranno incarnarsi in un corpo robotico.

È la tesi dell’embodiment, che vede nei robot umanoidi la frontiera ultima dell’AI.

Una sfida su cui si stanno cimentando colossi come Meta e startup visionarie come Figure.

Embodiment, la mente nel corpo

L’ipotesi dell’embodiment affonda le sue radici nella fenomenologia, la corrente filosofica che mette al centro l’esperienza vissuta del soggetto.

È un’intuizione che trova conferme nelle neuroscienze moderne, che hanno svelato l’intimo legame tra processi cognitivi e stati corporei, tra mappe cerebrali e schemi motori.

Pensare non è solo manipolare simboli, ma è sempre anche simulare scenari percettivi e piani d’azione, in un continuo rimando tra mente e corpo.

Un’AI potrà essere bravissima in compiti specifici, come giocare a scacchi o tradurre lingue, ma non svilupperà mai una comprensione profonda e flessibile del mondo, quella che deriva dall’esperienza incarnata.

Come diceva Hubert Dreyfus, filosofo critico dell’IA classica, un sistema simbolico può rappresentare il mondo, ma solo un agente incarnato può abitarlo.

E abitare il mondo significa esplorarlo con i sensi, manipolarlo con le mani, navigarlo con il corpo. È così che i bambini imparano, ed è così che dovranno imparare le AI per fare il salto verso l’intelligenza artificiale generale.

Nascere nel mondo virtuale

Ma come si fa a dare un corpo a un’intelligenza artificiale?

Qui che entrano in gioco le simulazioni, veri e propri “grembi virtuali” in cui far crescere le AI incarnate prima di rilasciarle nel mondo reale.

L’idea è di creare ambienti digitali fotorealistici che riproducano le leggi fisiche e le interazioni sociali del mondo reale, e di far “vivere” al loro interno avatar robotici controllati da reti neurali.

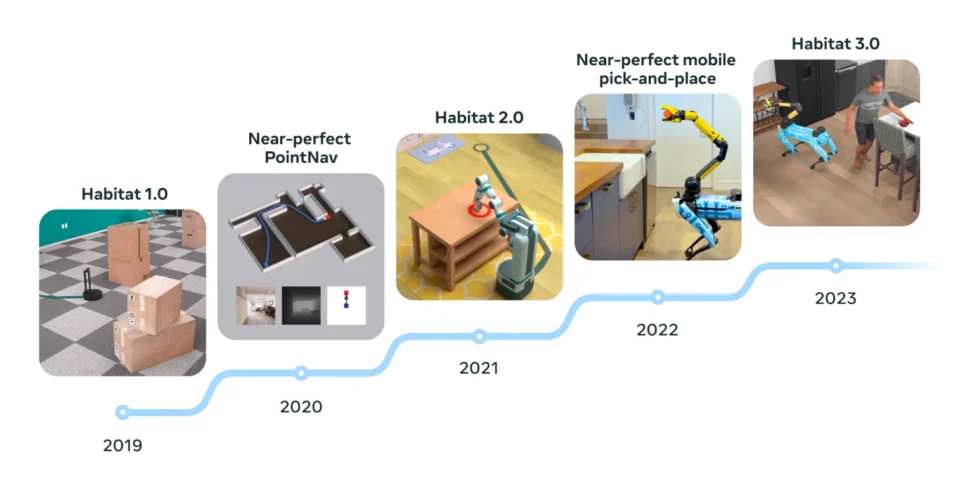

È l’approccio adottato da Meta con la sua piattaforma AI Habitat, lanciata nel 2019 e aggiornata anno per anno.

Habitat permette di addestrare agenti virtuali a eseguire compiti come aprire porte, prendere oggetti, navigare stanze ed edifici.

Compiti banali per un umano, ma molto complessi per un’intelligenza artificiale, che deve imparare a coordinare percezione, ragionamento e azione in un ambiente dinamico e incerto.

Le simulazioni consentono di accelerare enormemente i tempi di apprendimento, facendo accumulare alle AI millenni di esperienza in pochi giorni di calcolo.

E soprattutto, permettono loro di sbagliare senza conseguenze, schiantandosi contro i muri o facendo cadere gli oggetti senza danneggiare costosi robot fisici.

Le simulazioni hanno ovviamente anche dei limiti.

Per quanto realistiche, non possono replicare perfettamente la complessità del mondo reale, con le sue infinite variabili e interazioni.

C’è sempre un “gap di realtà” tra le prestazioni di un agente virtuale e quelle di un robot fisico, che può portare a comportamenti imprevisti o inefficaci.

Embodiment: dalla simulazione alla realtà

Ad un certo punto, come detto, bisogna far uscire le AI dalle loro culle virtuali e farle confrontare con la dura realtà. È il passaggio critico che stanno affrontando alcune delle startup più audaci del settore, come Figure, Agility Robotics o Apptronik per affiancare (e in qualche misura sostituire) il lavoro umano.

Dopo aver addestrato i loro robot umanoidi in simulazione, queste aziende li stanno inviando in ambienti reali, dalle case alle fabbriche (a partire dalle… fabbriche di robot), per validare le loro capacità cognitive e fisiche.

I robot di Agility sono già al lavoro nei centri logistici di Amazon, quelli di Figure stanno sperimentando l’assemblaggio nelle linee di produzione BMW, quelli di Apptronik invece sono impiegati in Mercedes.

Interfacciando il loro “cervello” con i più avanzati modelli linguistici di OpenAI, questi umanoidi sono in grado di comprendere comandi vocali, spiegare le loro azioni e apprendere compiti nuovi in pochi giorni.

I movimenti di questi robot sono ancora impacciati, la loro comprensione del linguaggio limitata, la loro autonomia ridotta.

Ma i progressi sono rapidissimi, e lasciano intravedere un futuro non troppo lontano in cui le macchine saranno davvero in grado di pensare e agire come noi, immerse nel nostro stesso mondo.

Leggi l’intero articolo al link sotto

FONTE: Futuro Prossimo

Inter

Intervista al dr Barrie Trower, celebre fisico inglese, esperto in armi a microonde. Ha lavorato per la Marina Reale ed i servizi segreti. È uno dei massimi espert mondiali di microonde, campi elettromagnetici e 5G Intervista del 2018, ma sempre attuale per una migliore comprensione.

“Il grilletto è già stato premuto con il wi-fi, il 5G è sol il passo successivo”

1.18 spiegazione frequenze 5G 2.30 Armi a microonde

4.15 Effetti sulla natura

5.28 Importanza vitale degli alberi

13.22 Effetti sulla popolazione di insetti, in particolare sulle api

15.51 Effetti biologici sulla salute umana

26.59 Sarebbe possibile generare una falsa epidemia con il 5G?

33.46 Conferenza internazionale top secret a Varsavia nel 1973. 300 pagine di documenti tuttora secretati.

44.37 Fibra ottica

47.18 Le persone usano la tecnologia in modo nevrotico. Siamo di fronte ad una sorta di pandemia?

49.00 Già dl 64 a.C. si sapeva che le radiazioni fotoniche che colpiscono gli occhi, procuravano diversi effetti sull’uomo

55.08 5G è la stessa tecnologia che utilizza il governo americano per controllare le folle?

56.57 Elon Musk ed i satelliti Starlink, perchè sono così importanti per il 5G?

01.01.20 Spiare attraverso il cellulare

01.06.18 Quali paesi non consentono il 5G?

01.14.08 Testimonianza del dr. Trower rilasciata in Oregon, sugli effetti delle microonde

01.20.40 Danno “termico” e “danno sotto-termico”

01.24.40 Cosa possiamo fare?